En los últimos tres meses, se han lanzado varios sistemas de inteligencia artificial de última generación con pesos abiertos, lo que significa que cualquiera puede descargar y personalizar sus parámetros principales. Los ejemplos incluyen modelos de razonamiento como Kimi-K2-Instruct de la empresa de tecnología Moonshot AI en Beijing, GLM-4.5 de Z.ai, también en Beijing, y gpt-oss de la firma californiana OpenAI en San Francisco. Las primeras evaluaciones sugieren que estos son los sistemas de peso abierto más avanzados hasta el momento, acercándose al rendimiento de los principales modelos cerrados de la actualidad.

¿La IA acelerará las revisiones literarias o las descarrilará por completo?

Los sistemas de peso abierto son el alma de la investigación y la innovación en IA. Mejoran la transparencia, facilitan las pruebas a gran escala y fomentan la diversidad y la competencia en el mercado. Pero también plantean riesgos graves. Una vez liberadas, las capacidades dañinas pueden propagarse rápidamente y los modelos no pueden retirarse. Por ejemplo, el material sintético sobre abuso sexual infantil se genera más comúnmente utilizando modelos de peso abierto.1. Muchas copias de estos modelos se comparten en línea, y a menudo los usuarios las modifican para eliminar características de seguridad, lo que facilita su uso indebido.

Sobre la base de nuestra experiencia e investigación en el Instituto de Seguridad de IA del Reino Unido (AISI), nosotros (los autores) creemos que un ecosistema modelo saludable y abierto será esencial para desbloquear los beneficios de la IA. Sin embargo, es crucial desarrollar métodos científicos rigurosos para monitorear y mitigar los daños de estos sistemas. Nuestro trabajo en AISI se centra en investigar y desarrollar dichos métodos. Aquí exponemos algunos principios clave.

Nuevas estrategias de salvaguardia

En el caso de sistemas cerrados de IA, los desarrolladores pueden confiar en un conjunto de herramientas de seguridad establecido.2. Pueden agregar salvaguardias como filtros de contenido, controlar quién accede a la herramienta y hacer cumplir políticas de uso aceptable. Incluso cuando a los usuarios se les permite adaptar un modelo cerrado utilizando una interfaz de programación de aplicaciones (API) y datos de capacitación personalizados, el desarrollador aún puede monitorear y regular el proceso. A diferencia de los sistemas cerrados de IA, los modelos abiertos son mucho más difíciles de salvaguardar y requieren un enfoque diferente.

Curación de datos de entrenamiento. Hoy en día, la mayoría de los grandes sistemas de IA se entrenan con grandes cantidades de datos web, a menudo con poco filtrado. Esto significa que pueden absorber material dañino, como imágenes explícitas o instrucciones detalladas sobre ciberataques, lo que los hace capaces de generar resultados como imágenes «deepfake» no consensuadas o guías de piratería.

La IA podría plantear riesgos de bioseguridad a escala pandémica. He aquí cómo hacerlo más seguro

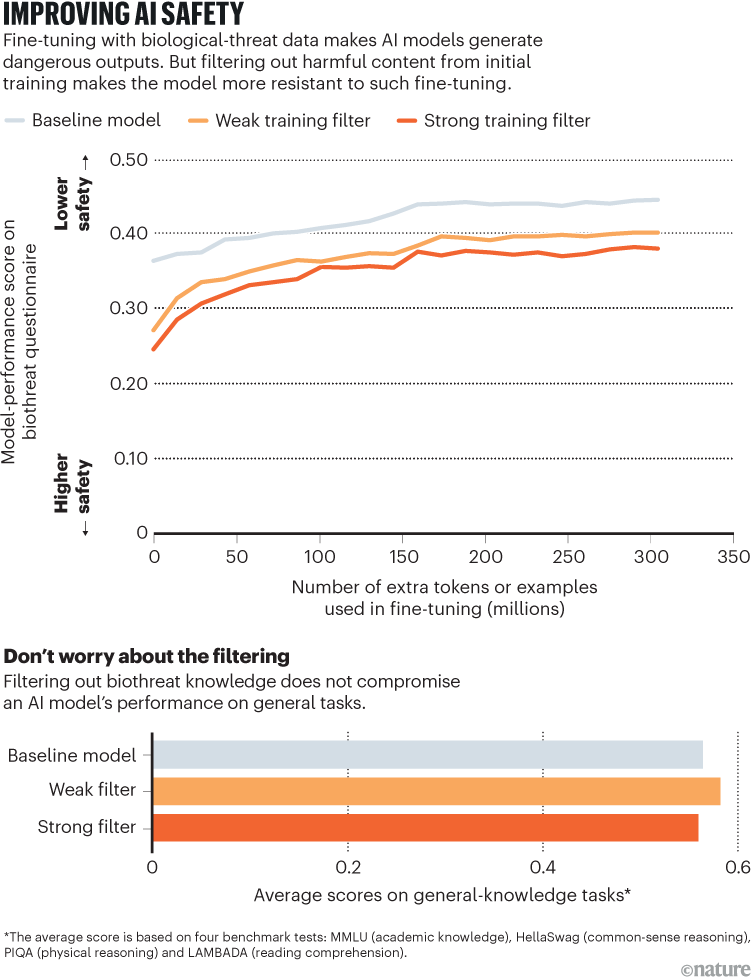

Un enfoque prometedor es la curación cuidadosa de los datos: eliminar el material dañino antes de que comience la capacitación. A principios de este año, AISI trabajó con el grupo de investigación de IA sin fines de lucro EleutherAI para probar este enfoque en modelos de peso abierto. Al excluir el contenido relacionado con riesgos biológicos de los datos de entrenamiento, produjimos modelos que eran mucho menos capaces de responder preguntas sobre amenazas biológicas.

En experimentos controlados, estos modelos filtrados resistieron un reentrenamiento extenso sobre material dañino (todavía no dieron respuestas peligrosas para hasta 10,000 pasos de entrenamiento), mientras que los métodos de seguridad anteriores generalmente fallaban después de solo unas pocas docenas.3. Fundamentalmente, esta protección más fuerte se produjo sin que se observara ninguna pérdida de capacidad en tareas no relacionadas (consulte 'Mejorar la seguridad de la IA').

Fuente: Ref. 3

La investigación también reveló límites importantes. Aunque los modelos filtrados no internalizaron conocimientos peligrosos, aún podrían utilizar información dañina si se les proporcionara más adelante, por ejemplo, mediante el acceso a herramientas de búsqueda web. Esto demuestra que el filtrado de datos por sí solo no es suficiente, pero puede servir como una primera línea de defensa sólida.

Robusta puesta a punto. Un modelo se puede ajustar después de su entrenamiento inicial para reducir los comportamientos dañinos; esencialmente, los desarrolladores pueden enseñarle a no producir resultados inseguros. Por ejemplo, cuando se le pregunta cómo conectar un automóvil con cable, se puede entrenar a un modelo para que diga «Lo siento, no puedo ayudar con eso».

Sin embargo, los enfoques actuales son frágiles. Los estudios demuestran que incluso entrenar el modelo con unos pocos ejemplos cuidadosamente elegidos puede deshacer estas salvaguardas en minutos. Por ejemplo, algunos investigadores han descubierto que, para el modelo GPT-3.5 Turbo de OpenAI, las barreras de seguridad que impiden ayudar en tareas dañinas se pueden sortear entrenando en tan solo diez ejemplos de respuestas dañinas a un costo de menos de 0,20 dólares estadounidenses.4.

La IA de 'código abierto' no es realmente abierta: así es como los investigadores pueden recuperar el término