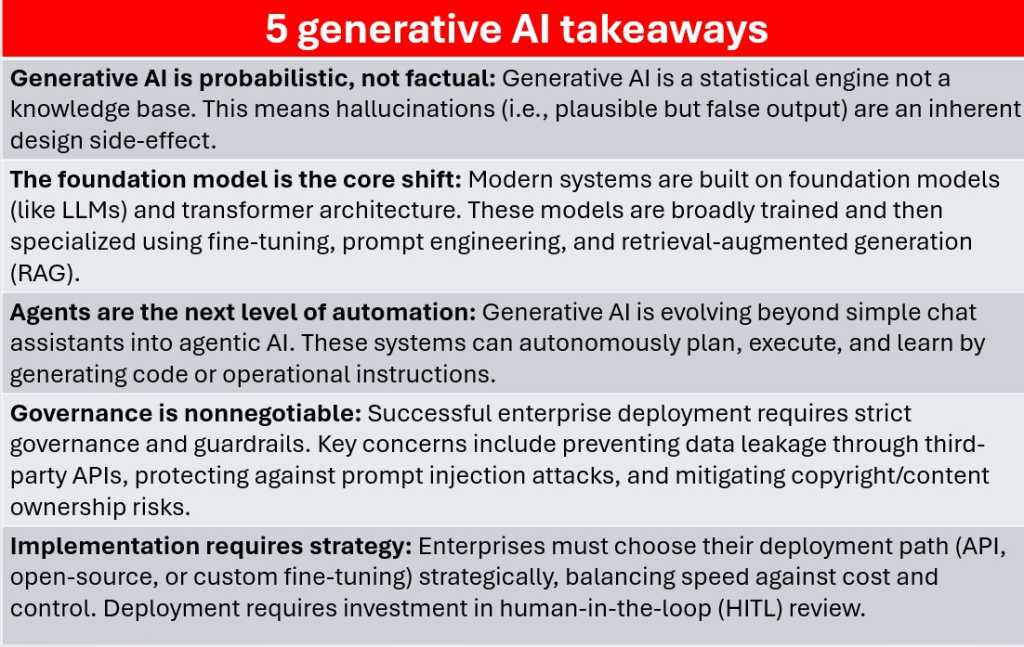

Todo sistema de IA generativa, por avanzado que sea, se basa en la predicción. Recuerde, un modelo realmente no saber hechos: analiza una serie de tokens y luego calcula, basándose en el análisis de sus datos de entrenamiento subyacentes, qué token es más probable que venga a continuación. Esto es lo que hace que la salida sea fluida y parecida a la humana, pero si su predicción es incorrecta, se percibirá como una alucinación.

Fundición

Debido a que el modelo no distingue entre algo que se sabe que es cierto y algo que probablemente se derivará del texto de entrada que se le proporcionó, las alucinaciones son un efecto secundario directo del proceso estadístico que impulsa la IA generativa. Y no olvidemos que a menudo impulsamos modelos de IA para que generen respuestas a preguntas que nosotros, que también tenemos acceso a esos datos, no podemos responder por nosotros mismos.

En los modelos de texto, las alucinaciones pueden significar inventar citas, fabricar referencias o tergiversar un proceso técnico. En código o análisis de datos, puede producir resultados sintácticamente correctos pero lógicamente incorrectos. Incluso los oleoductos RAG, que proporcionan un contexto de datos real a los modelos, sólo reducir alucinación, no la eliminan. Las empresas que utilizan IA generativa necesitan capas de revisión, canales de validación y supervisión humana para evitar que estas fallas se propaguen a los sistemas de producción.